Buget 9 Sfaturi de optimizare site-ului kraulingovogo

Ce asociați expresia „optimizarea motorului de căutare“? Mulți imediat vine în minte o listă de factori de rang, cum ar fi etichetele potrivite, cuvinte cheie relevante, sitemap, clare și conținut de calitate. Dar există un alt aspect important - bugetul kraulingovy.

Mulți SEO-experți nu acorde atenție la acest factor, nu înțelege destul de punctul său. Cu toate acestea bugetul kraulingovy poate și ar trebui să fie optimizate. Acest lucru va fi discutat în articol.

Care este site-ul kraulingovy buget?

Servicii de web și motoarele de căutare folosesc păianjeni robotice speciale care accesează cu crawlere web și adăugați-le la index. Crawlere defini, de asemenea link-uri către pagini și mutați-le pentru a scana celelalte pagini.

Printre roboții motoarelor de căutare apar Googlebot, Bingbot și altele. Multe SEO-unelte folosesc, de asemenea, păianjeni pentru a aduna informații.

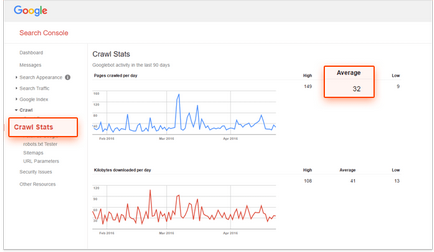

Termenul „Bugetul kraulingovy“ se referă la numărul de pagini care crawler pot fi ocolite pentru o anumită perioadă de timp. În cazul în care Googlebot scanează 32 de pagini pe zi, bugetul kraulingovy luni va fi 960 de pagini.

Se determină site-ul kraulingovy bugetului aproximative, puteți utiliza servicii, cum ar fi Google Search Console și Bing Webmaster Tools. Pentru a face acest lucru, deschideți raportul, „Statistici de crawl“ și a vedea cât de mult, în paginile scanate în medie pe zi.

Buget kraulingovogo Optimizare SEO =?

Da și nu. Deși ambele tipuri de optimizare sunt destinate pentru a face mai multe pagini vizibile pentru motoarele de căutare, ele sunt diferite în natură.

SEO pune mai mult accent pe experiența utilizatorului și site-ul de indexare optimizare axat pe roboți motor de căutare. În cuvintele fondatorului KISSmetrics Neil Patel:

«SEO este axat pe optimizarea procesului de cereri de utilizator. Optimizat pentru Googlebot - cu privire la modul Google obține acces de căutare robot de pe site-ul ".

Cum de a optimiza kraulingovy bugetul

Dacă nu doriți ca pagina să apară în rezultatele de căutare, trebuie să refuze accesul la acesta în .htaccess și robots.txt. Cu toate acestea, în conformitate cu Google. una din directivele Disallow robots.txt nu este de ajuns:

„Directiva Disallow nu garantează absența paginii în rezultatele căutării. Google poate scana, luând în considerare informațiile relevante terțe părți, cum ar fi link-uri primite. Dacă doriți să fie strict interzisă indexarea paginii, utilizați roboți meta tag-ul cu o valoare NOINDEX sau HTTP-antet X-Robots-Tag. În acest caz, nu blochează accesul la pagina în robots.txt, pentru că roboții Google să-l scanați pentru a găsi eticheta și să execute directiva. "

Roboții meta tag-ul cu un atribut noindex. Puneți-l în secțiunea

pagina:X-Robots-Tag. Titlul X-Robots-Tag poate fi un element de HTTP-la poziția pentru o anumită adresă URL. Directiva noindex, care pot fi utilizate în meta roboți, și este de asemenea aplicabil X-Robots-Tag:

Acum, Google poate ocupa cele mai multe tipuri de fișiere multimedia, dar nu toate motoarele de căutare se poate. Prin urmare, aceste fișiere trebuie utilizat cu precauție. Acesta poate fi rezonabil, și le-a dat până la acele pagini pe care doriți să le vedeți în rezultatele căutării.

O listă cu toate tipurile de fișiere pe care Google poate indexa, poate fi găsit aici.

Problema dacă link-urile rupte din clasament, a declarat că odată ce influența purtătorul de cuvânt al Google Dzhon Myuller. „Nu, este important în primul rând pentru utilizatori.“

În cazul în care cuvintele sale - cu toate acestea, este una dintre diferențele fundamentale dintre SEO și optimizarea pentru motoarele de căutare. Link-uri sparte nu joacă un rol semnificativ în clasament, chiar dacă acestea sunt dificil de Googlebot indexarea și clasificarea site-ului.

Cu toate acestea, algoritmii Google sunt îmbunătățite în fiecare an, și tot ce afectează interfața de utilizare, poate afecta în cele din urmă rezultatele căutării.

Căutare roboți ocupa URL-ul dinamic, ceea ce duce la aceeași pagină ca pagini diferite. Acest lucru înseamnă că, în acest fel pot fi cheltuite kraulingovy buget. Puteți controla parametrii URL-ul din consola de căutare Google. Pentru a face acest lucru, mergeți la „Setări URL» secțiune. Aici puteți spune Google, cum să se ocupe de un URL, care conțin un anumit parametru. Astfel, va fi posibil pentru a elimina conținutul duplicat pe site.

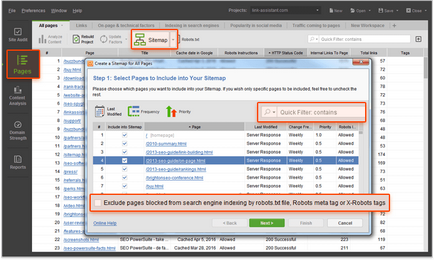

Fișier XML Sitemap și ajută utilizatorii și păianjeni motor de căutare, organizarea conținutului și făcându-l mai ușor de căutare. Păstrați sitemap la curent și curățați-l de orice lucru care ar putea afecta gradul de utilizare a resursei: paginile care returnează o eroare 4xx, redirecționări inutile, adresă URL non-canonice, și blocate de indexare.

Pentru a aduce o hartă a site în ordine, puteți utiliza instrumentul Cenzorul site-ul. Cu XML Sitemap Generator poate crea o nouă hartă site care va fi lipsesc din paginile blocate indexate. În Auditul site-ul va fi ușor de găsit, revenind 4xx pagini de eroare 301 și 302 redirecționări și pagini non-canonice.

RSS-feed au fost mult timp considerată o modalitate bună de a crește implicarea utilizatorilor. De asemenea, ele sunt printre resursele care sunt cel mai des vizitate de Googlebot. În cazul în care site-ul se actualizează, transmite aceste informații la FeedBurner de la Google, deci este bine indexat.

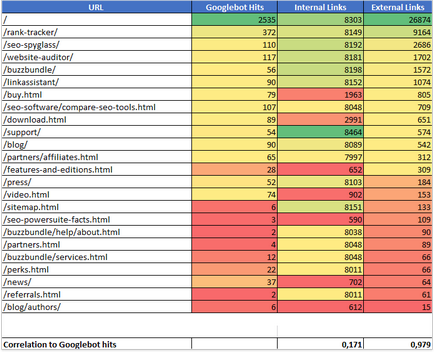

Un experiment recent Johan Kutarnyuka a aratat ca inbound link-uri sunt corelate cu numarul de vizite la site-ul dvs. de către motorul de căutare păianjeni.

În timpul experimentului Kutarnyuk identificat toate link-urile interne și externe care indică fiecare pagină pe 11 site-uri diferite. El a analizat apoi statisticile pentru fiecare pagină, și a comparat rezultatele. Mai jos - datele obținute de la unul dintre site-urile:

o corelație puternică a fost găsită în experiment (0.978) între numărul de vizite la robot de căutare site-ul și numărul de link-uri externe.

Kutarnyuka experiment a arătat că referința internă nu afectează în mod semnificativ viteza de scanare. Cu toate acestea, acest lucru nu înseamnă că acestea ar trebui să fie ignorate. Structura-Gândite a site-ului permite roboților de căutare pentru a găsi conținut fără a cheltui kraulingovy bugetul irosit.

structură logică și bine gândită de link-uri interne, de asemenea, îmbunătăți experiența utilizatorului - mai ales în cazul în care vizitatorul poate ajunge la orice loc în site-ul în trei clicuri. Facilitarea accesului la conținutul asigură faptul că utilizatorii petrec pe site-ul mai mult timp. Ca rezultat, se poate îmbunătăți clasament.

concluzie

Optimizarea bugetului site-ul kraulingovogo - este o parte importantă a SEO-experți, și ar trebui să facă. Când Google facilitează indexarea resursei, roboți păianjeni de multe ori este vizitat, iar actualizarea va apărea în rezultatele căutării. Tu de asemenea, îmbunătățește experiența de interacțiune cu utilizatorii site-ului, care în cele din urmă duce la creșterea poziției sale în căutare.